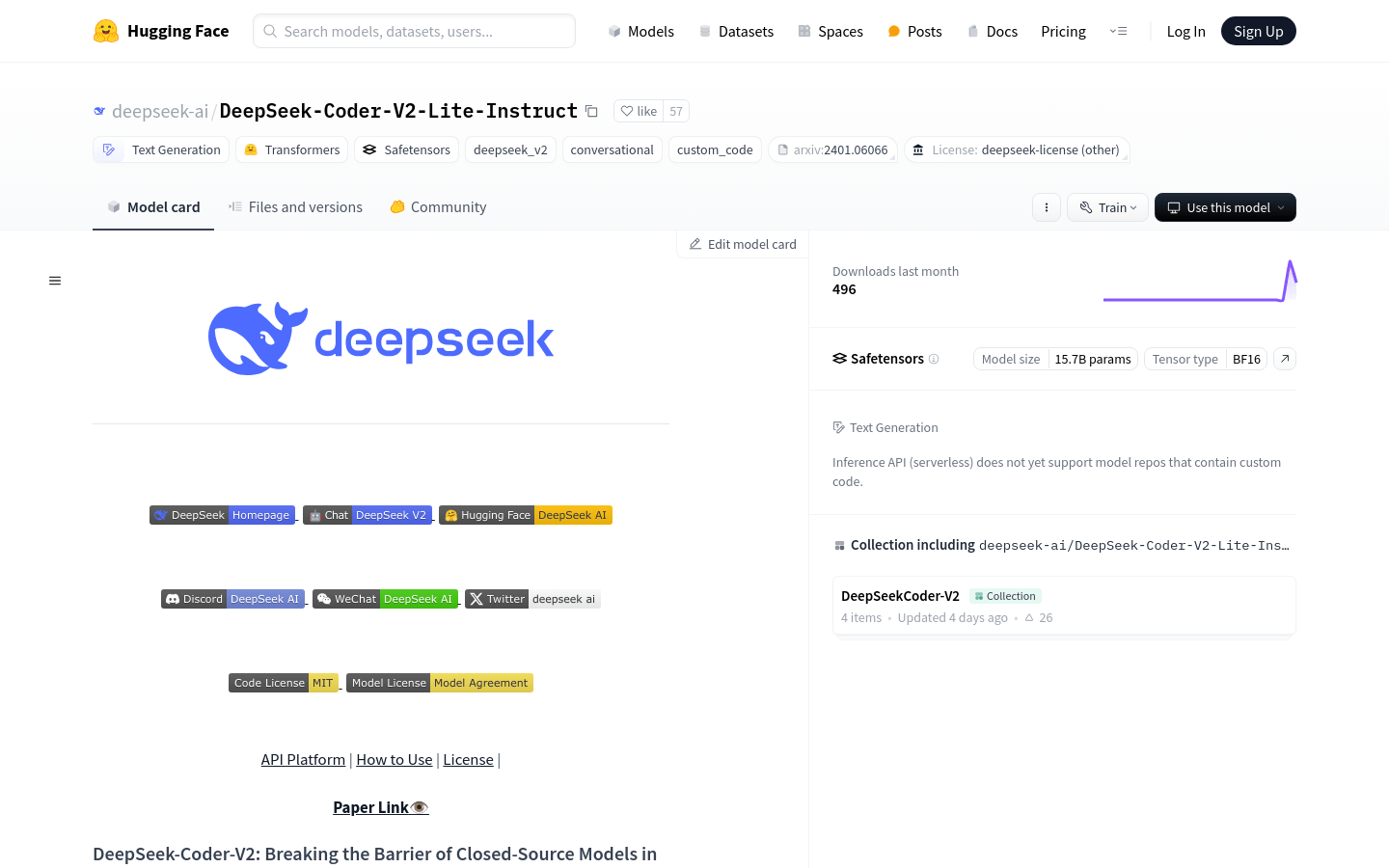

DeepSeek-Coder-V2-Lite-Instruct

代码生成

数学推理

国外精选

DeepSeek-Coder-V2是一个开源的Mixture-of-Experts代码语言模型,性能可与GPT4-Turbo相媲美,在代码特定任务上表现突出。它通过额外的6万亿个token进一步预训练,增强了编码和数学推理能力,同时保持了在一般语言任务上的相似性能。与DeepSeek-Coder-33B相比,在代码相关任务、推理和一般能力方面都有显著进步。此外,它支持的编程语言从86种扩展到338种,上下文长度从16K扩展到128K。

需求人群:

"DeepSeek-Coder-V2适合需要进行代码生成、代码推理和数学问题解决的开发者和数据科学家。它通过提供强大的语言理解和生成能力,帮助用户在编程和算法开发中提高效率。"

使用场景示例:

开发者使用DeepSeek-Coder-V2生成快速排序算法的代码。

数据科学家利用模型进行复杂的数学公式推理。

教育工作者使用该模型辅助编程教学,提高学生学习效率。

浏览量:8

类似应用