MoA

AI

语言模型

国外精选

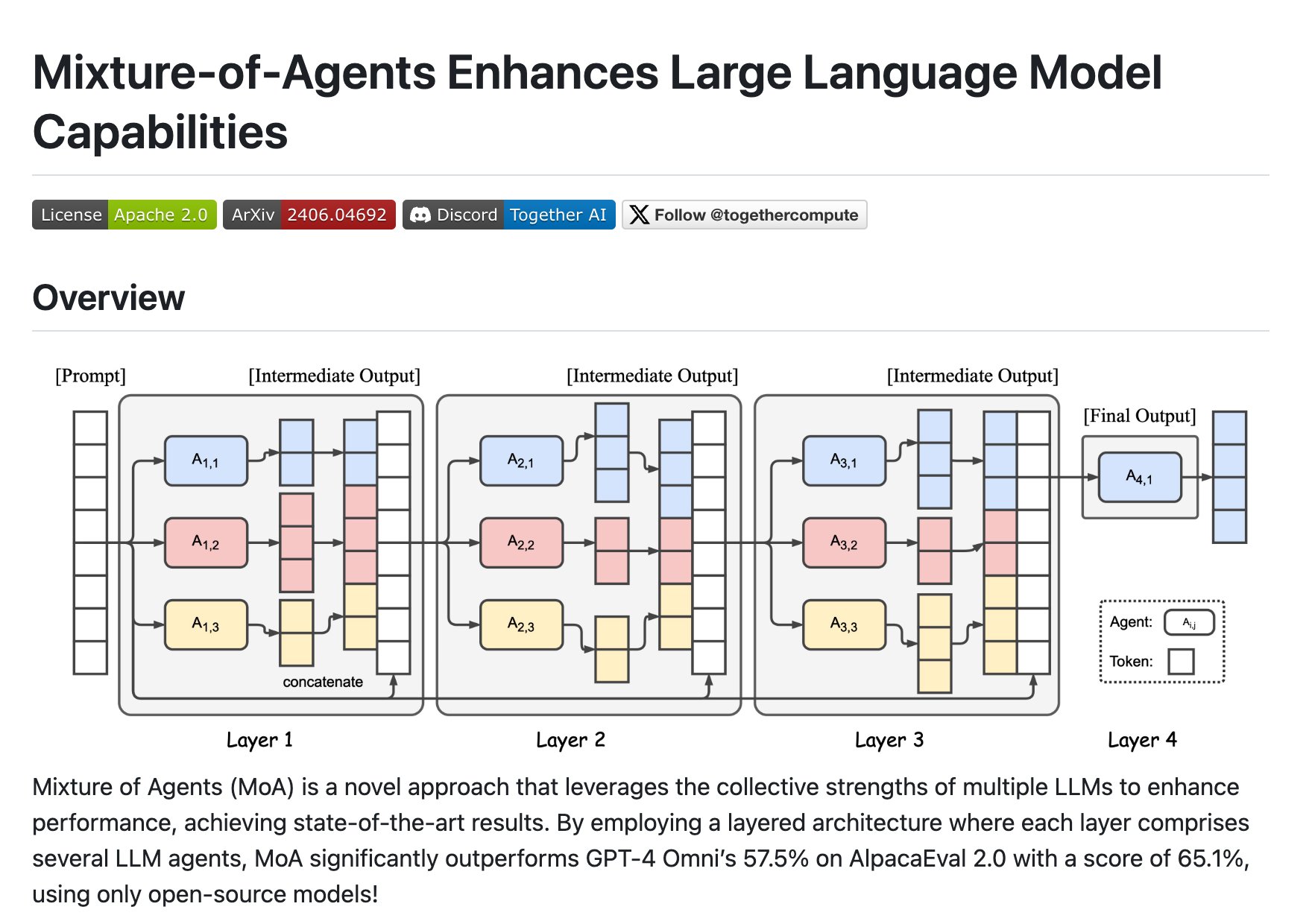

MoA(Mixture of Agents)是一种新颖的方法,它利用多个大型语言模型(LLMs)的集体优势来提升性能,实现了最先进的结果。MoA采用分层架构,每层包含多个LLM代理,显著超越了GPT-4 Omni在AlpacaEval 2.0上的57.5%得分,达到了65.1%的得分,使用的是仅开源模型。

需求人群:

"MoA主要面向AI研究人员和开发者,特别是那些专注于提升语言模型性能和寻求开源解决方案的专业人士。MoA的技术背景和主要优点使其成为希望在自然语言处理领域取得突破的研究者和开发者的理想选择。"

使用场景示例:

在AlpacaEval 2.0上实现7.6%的绝对提升

在FLASK评估中,在无害性、鲁棒性等多个维度上超越GPT-4 Omni

通过自定义配置实现个性化的多轮对话体验

浏览量:5

类似应用