Gemma-2B-10M

语言模型

注意力机制

国外精选

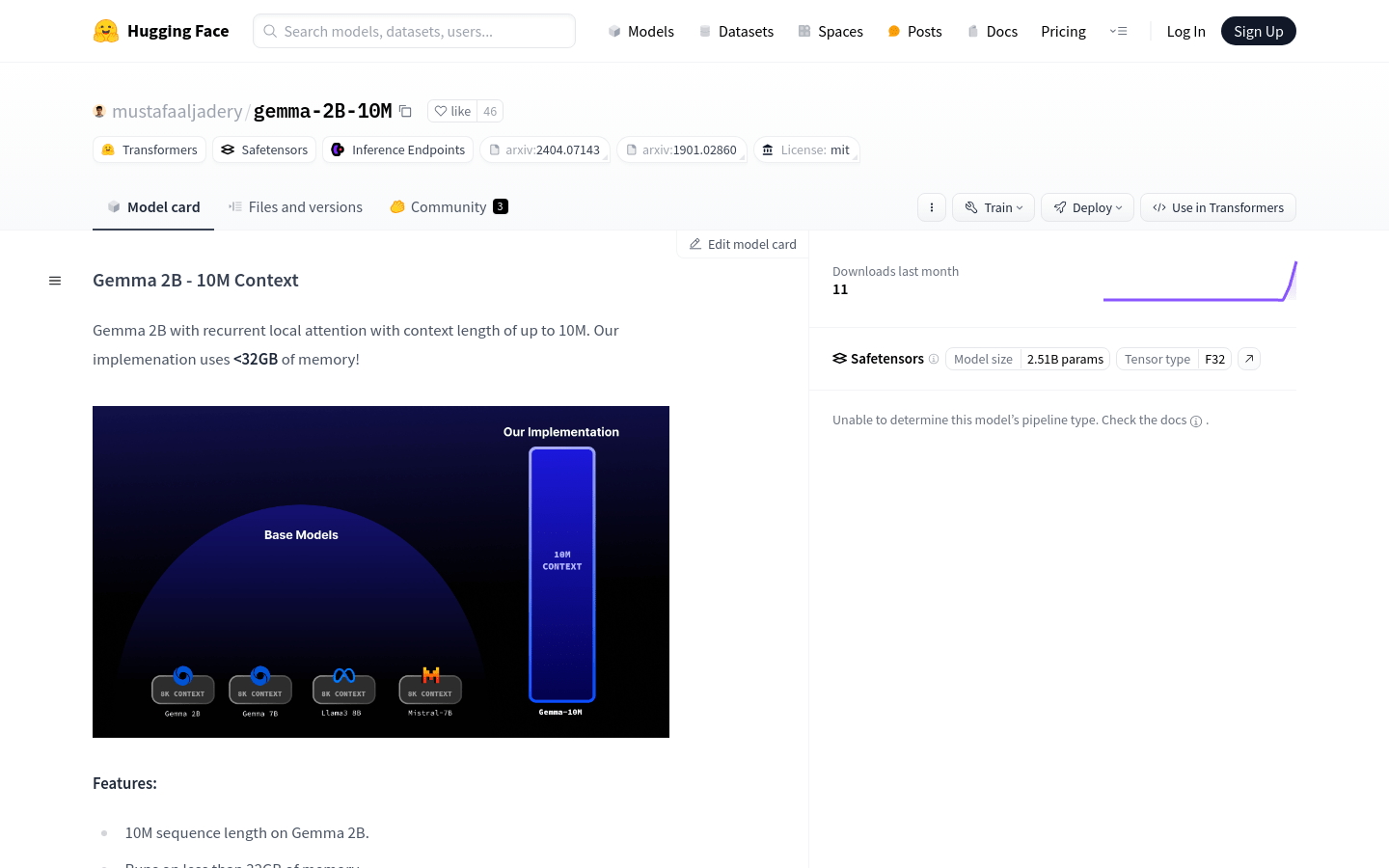

Gemma 2B - 10M Context是一个大规模的语言模型,它通过创新的注意力机制优化,能够在内存使用低于32GB的情况下处理长达10M的序列。该模型采用了循环局部注意力技术,灵感来源于Transformer-XL论文,是处理大规模语言任务的强大工具。

需求人群:

适用于需要处理大量文本数据的研究人员和开发者

适合进行长文本生成、摘要、翻译等语言任务

对于追求高性能和资源优化的企业用户具有吸引力

使用场景示例:

使用Gemma 2B - 10M Context生成《哈利波特》系列书籍的摘要

在教育领域中,为学术论文自动生成概要

在商业领域,为产品描述和市场分析自动生成文本内容

浏览量:28

类似应用