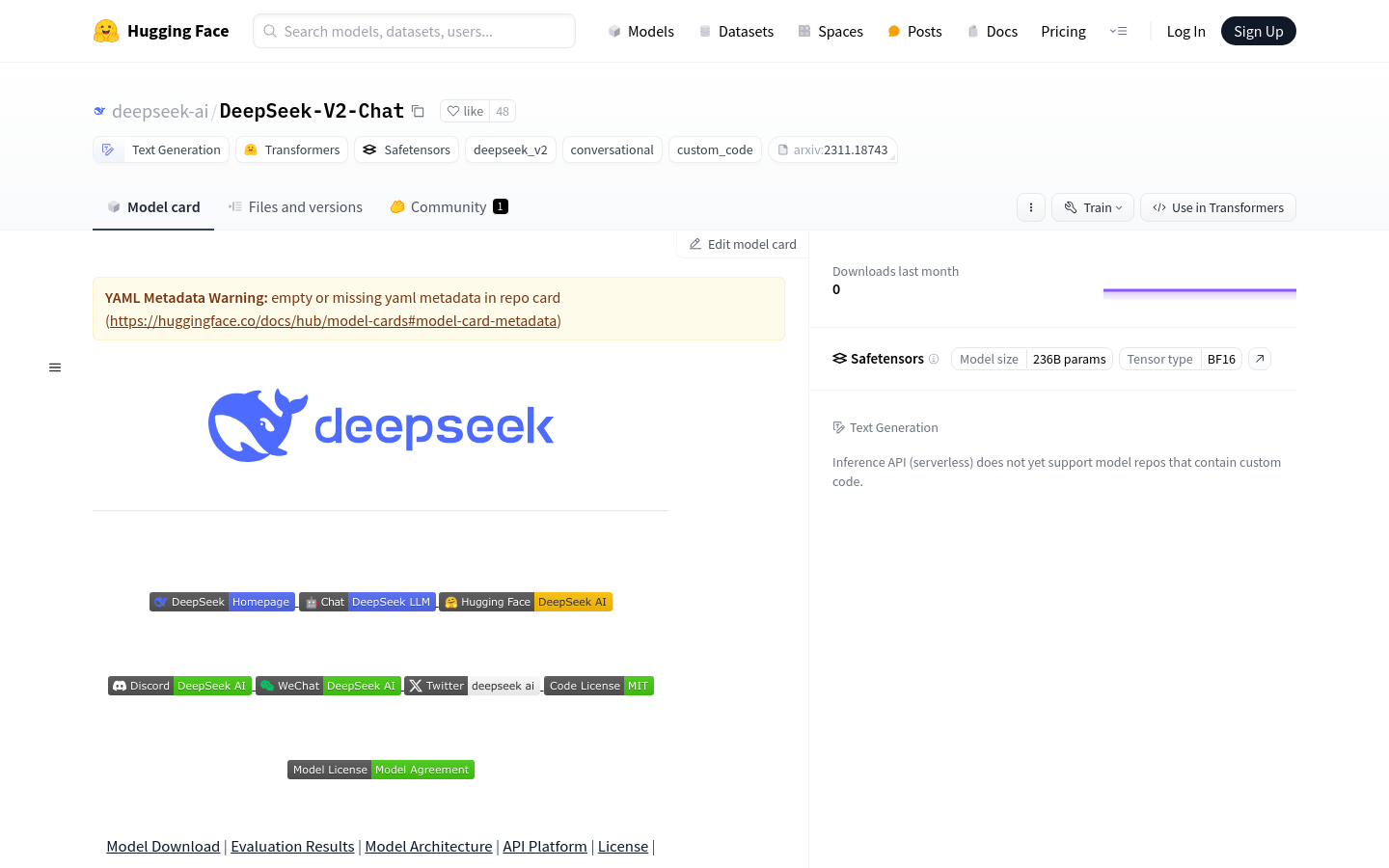

DeepSeek-V2-Chat

语言模型

混合专家

国外精选

DeepSeek-V2是一个由236B参数构成的混合专家(MoE)语言模型,它在保持经济训练和高效推理的同时,激活每个token的21B参数。与前代DeepSeek 67B相比,DeepSeek-V2在性能上更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,并提升了最大生成吞吐量至5.76倍。该模型在8.1万亿token的高质量语料库上进行了预训练,并通过监督式微调(SFT)和强化学习(RL)进一步优化,使其在标准基准测试和开放式生成评估中表现出色。

需求人群:

适用于需要高效语言模型的企业和开发者

适合进行大规模文本生成和处理的任务

适用于需要优化成本同时追求高性能的场景

为用户提供了强大的文本生成和对话能力

使用场景示例:

用于开发智能客服系统,提升客户服务效率

集成到编程辅助工具中,帮助开发者快速生成代码

作为聊天机器人的后端,提供流畅自然的对话体验

浏览量:147

类似应用