MetaCLIP

机器学习

图像识别

国外精选

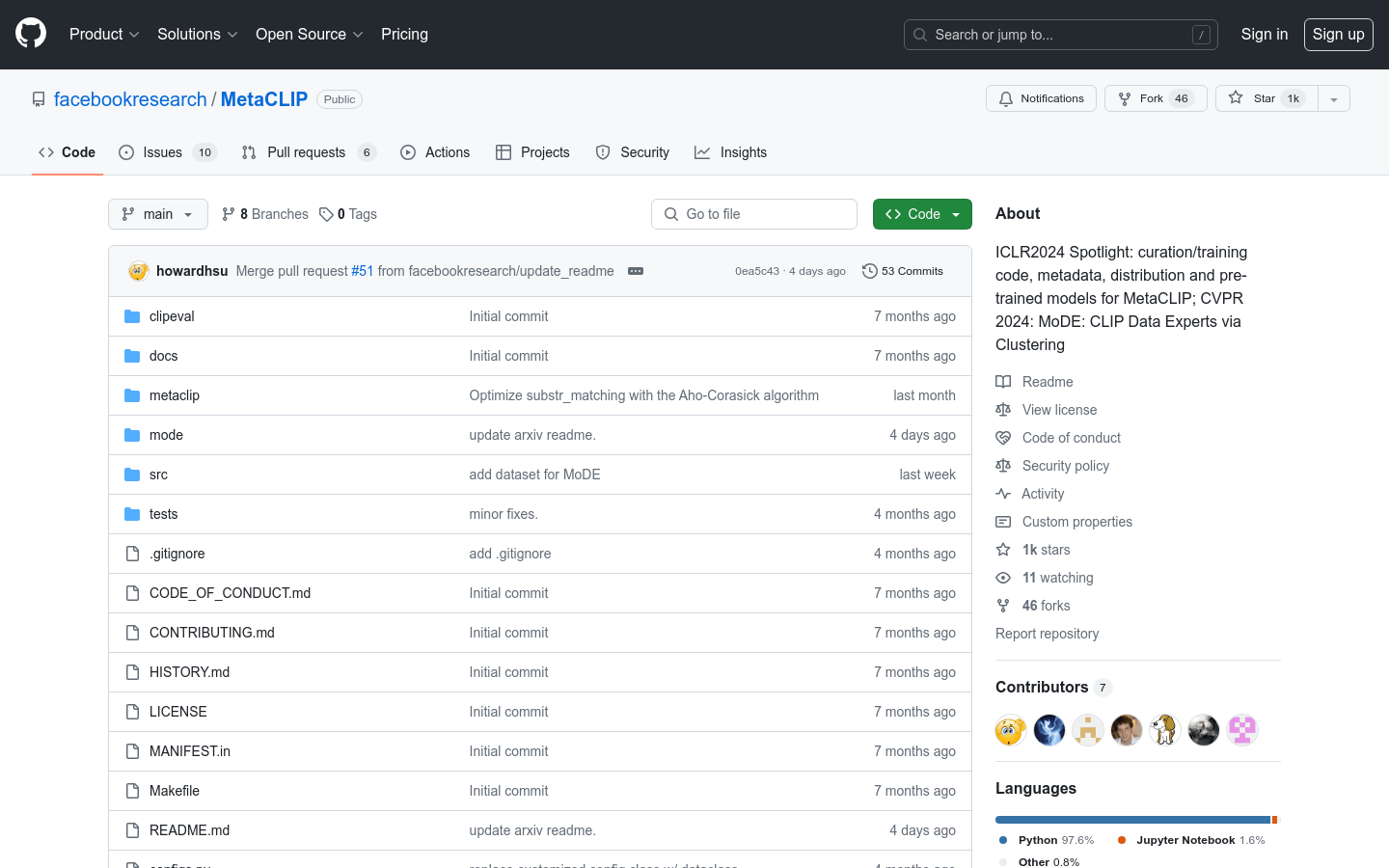

MetaCLIP是一个开源的机器学习模型,用于图像和文本的联合表示学习。它通过一个简单算法对CLIP数据进行筛选,不依赖于先前模型的过滤,从而提高了数据的质量和透明度。MetaCLIP的主要贡献包括无过滤的数据筛选、透明的训练数据分布、可扩展的算法和标准化的CLIP训练设置。该模型强调数据质量的重要性,并提供预训练模型,以支持研究人员和开发者进行控制实验和公平比较。

需求人群:

研究人员:可以利用MetaCLIP进行图像和文本的联合表示学习研究

开发者:可以集成MetaCLIP模型到他们的应用程序中,提升图像识别和文本处理能力

数据科学家:可以使用MetaCLIP的算法来改进自己的数据处理流程,提高数据质量

使用场景示例:

在图像检索任务中,使用MetaCLIP模型来提高检索的准确性

在社交媒体内容分析中,利用MetaCLIP模型理解图像和相关文本的关联

在教育领域,使用MetaCLIP模型来辅助图像和文本的教学材料开发

浏览量:18

类似应用